干货分享丨AGV搬运机器人多传感器融合的实时避障技术

- 2025-05-28 09:33:36

- 1922

- aiten

一、AGV多传感器融合实时避障系统介绍

1.简介

传感器融合技术是机器人实现全覆盖避障的关键,其原理仿效人脑综合处理信息的方式:通过协调多种传感器(如激光雷达、视觉摄像头等)进行多层次、多维度的信息整合,弥补单一传感器的局限,最终构建出对环境的一致性感知。该技术既能融合多源数据的互补优势(如精准测距与物体识别),又能通过智能算法优化信息处理流程,使AGV(自动导引车)在复杂动态环境中同步提升避障精度与环境适应力。

2.提高检测精度

融合激光雷达(精确测距,但强光易干扰)、视觉(识别物体类型,弱光受限)及超声波(近距盲区探测)等多传感器数据,互补短板,增强障碍物识别准确性。

3.强化系统可靠性

冗余设计确保单一传感器故障时(如激光雷达失效),其他传感器仍可维持避障;结合卡尔曼滤波等算法,滤除噪声干扰,提升数据稳定性。

4.扩展环境适应性

动态切换优势传感器应对复杂场景,如电磁干扰时选用抗扰数据、烟雾环境中融合超声波与激光雷达,并针对透明/悬空障碍物启用红外等专项传感器。

5.优化避障决策

通过多传感器分区感知(如前方划设避障/绕行区),综合障碍物距离(激光雷达)、类型(视觉)及近距信息(超声波),生成全局环境模型,精准规划最优路径。

二、多传感器融合避障原理

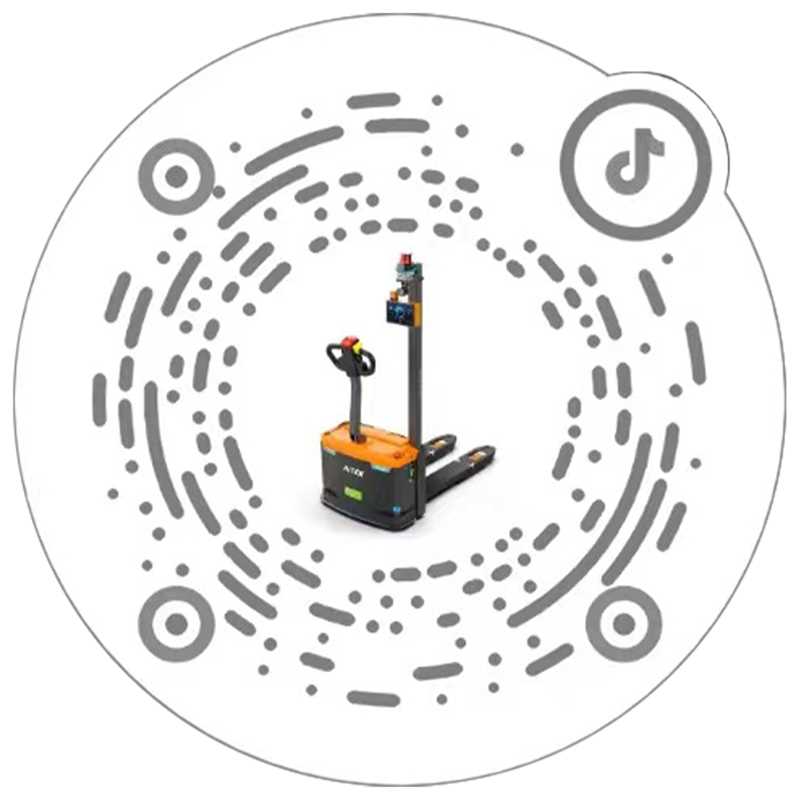

1.典型布局

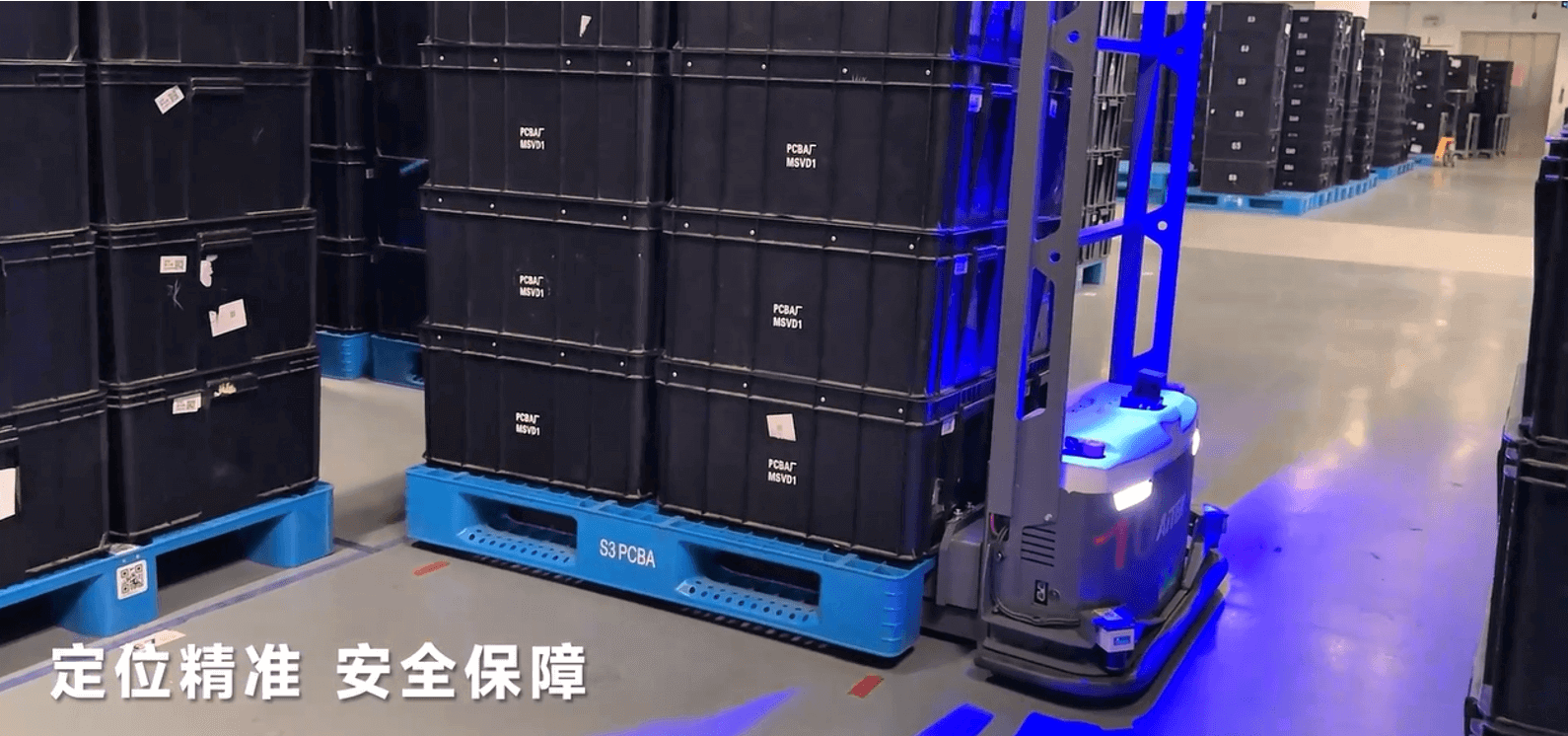

前方主避障:左右2D激光水平扫描障碍,底部超声波补充低矮障碍检测,前上方斜置3D激光覆盖立体空间。

侧向防护:两侧斜装深度相机,消除AGV横向盲区。

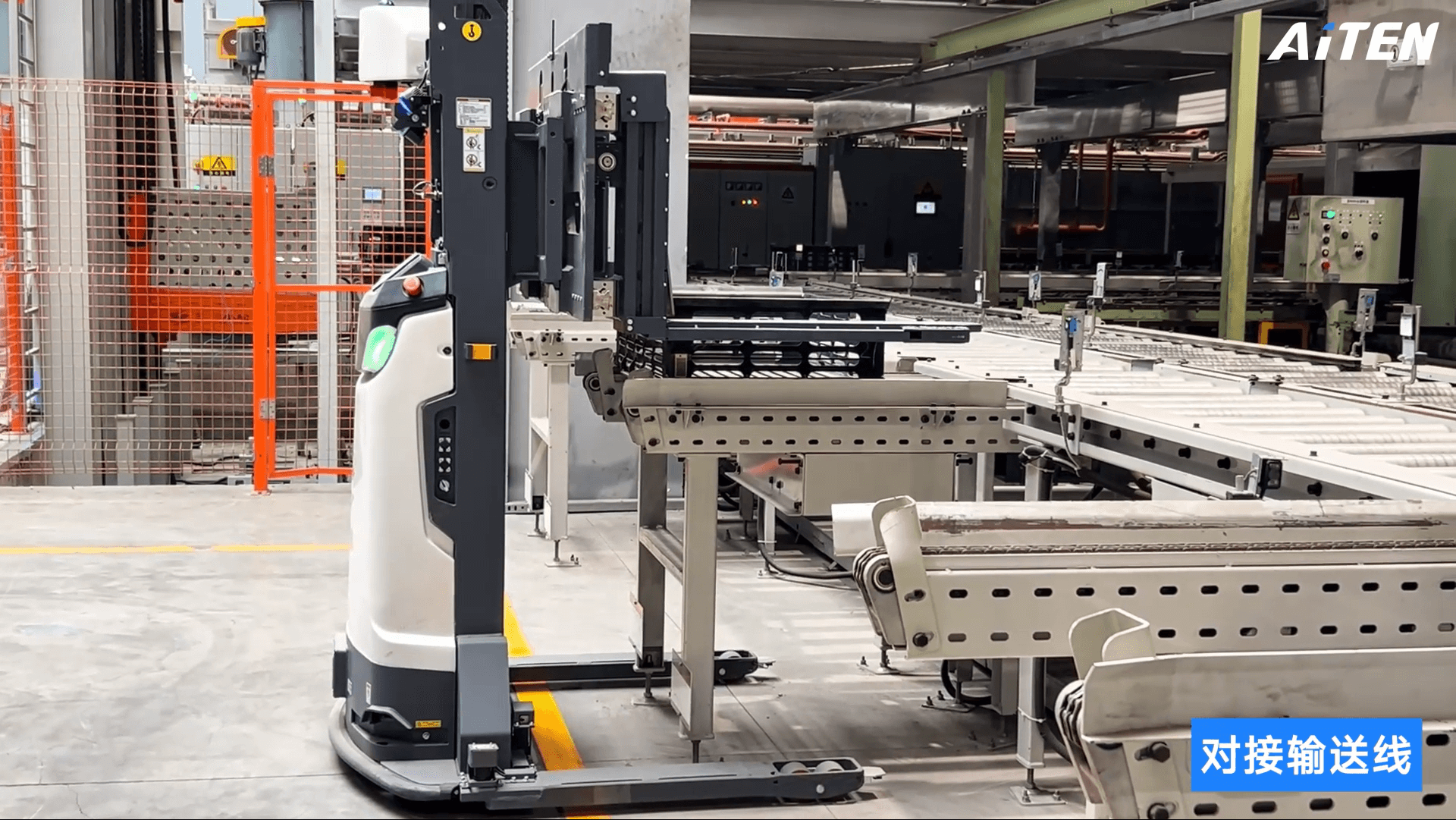

货叉防撞:货叉搭载IMU实时监测姿态,结合上下3D激光数据,动态预测货叉运动轨迹并防护周边区域。

叉间防撞:双超声波传感器监控车尾两侧扇形区域障碍物。

(↑多传感器融合典型布局图)

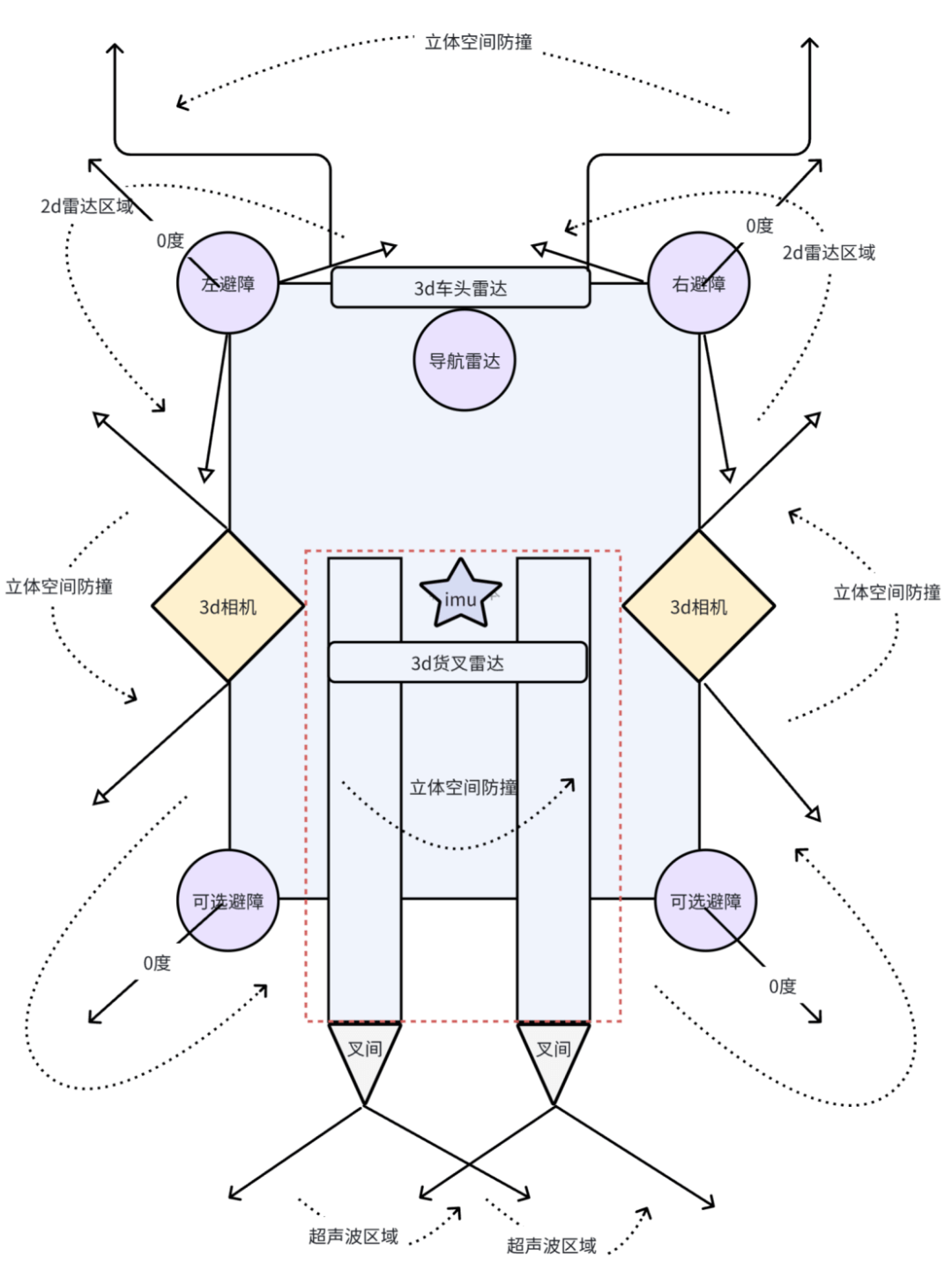

2.融合方法

数据级:统一多传感器时间戳与坐标系,直接合并点云数据。

特征级:融合激光雷达边缘特征与视觉SIFT特征,利用PointNet++(点云)和CNN(图像)进行深度学习,或通过EKF生成障碍物概率地图。

决策级:贝叶斯网络动态加权各传感器置信度,紧急场景超声波触发急停,激光雷达规划绕行路径。

(↑多传感器紧耦合融合经典方法)

3.环境感知

远近分工:3D雷达点云检测远端全局障碍,深度相机识别近端局部障碍。

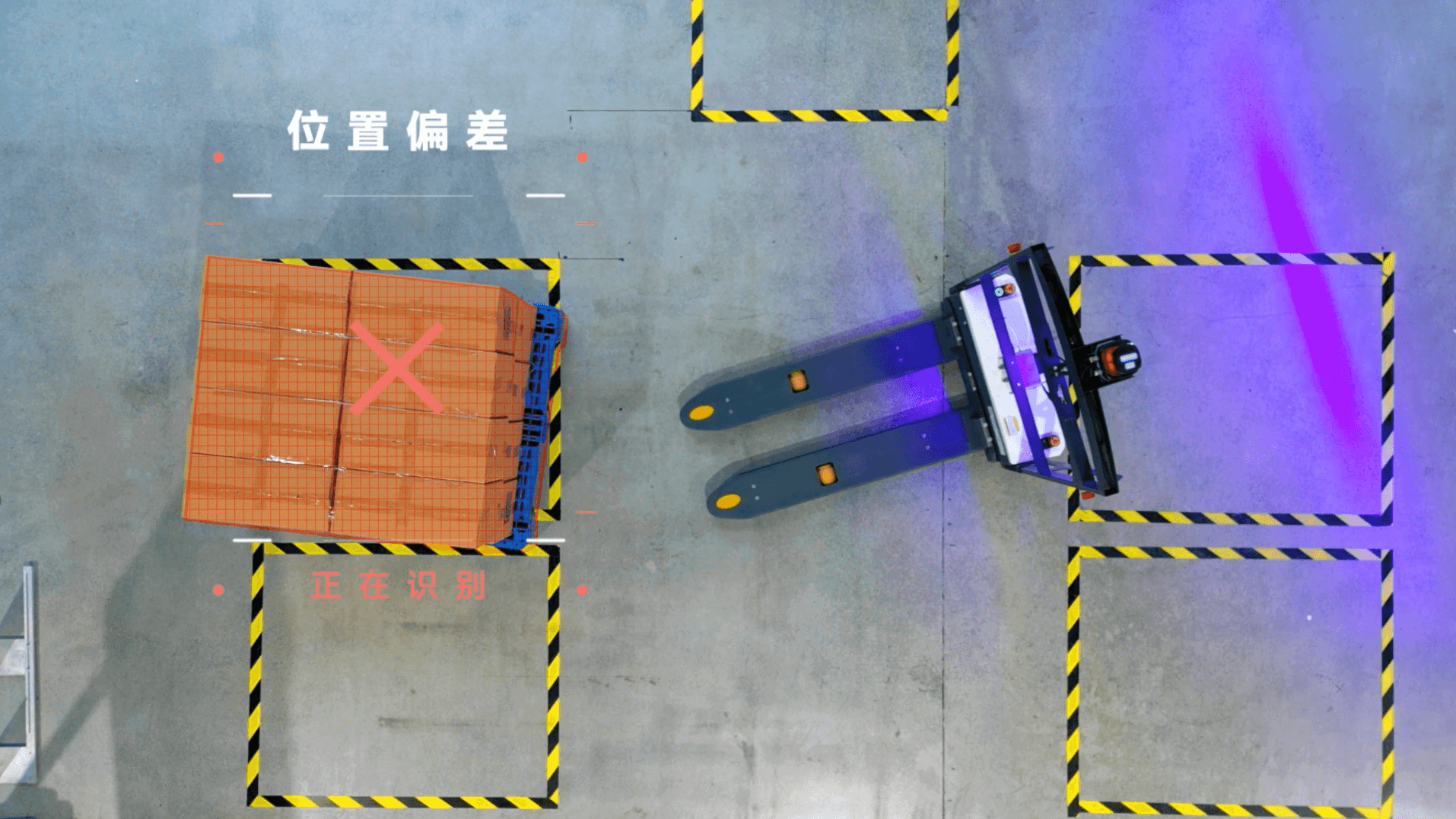

障碍物定义:包括人员、货物、叉车等具有体积的物体,核心流程为“检测→跟踪→定位”(确认存在→轨迹预测→距离计算)

语义地图:通过实例分割标注障碍物类别(如货架、电梯),提取轮廓映射至地图,支撑智能避障决策。

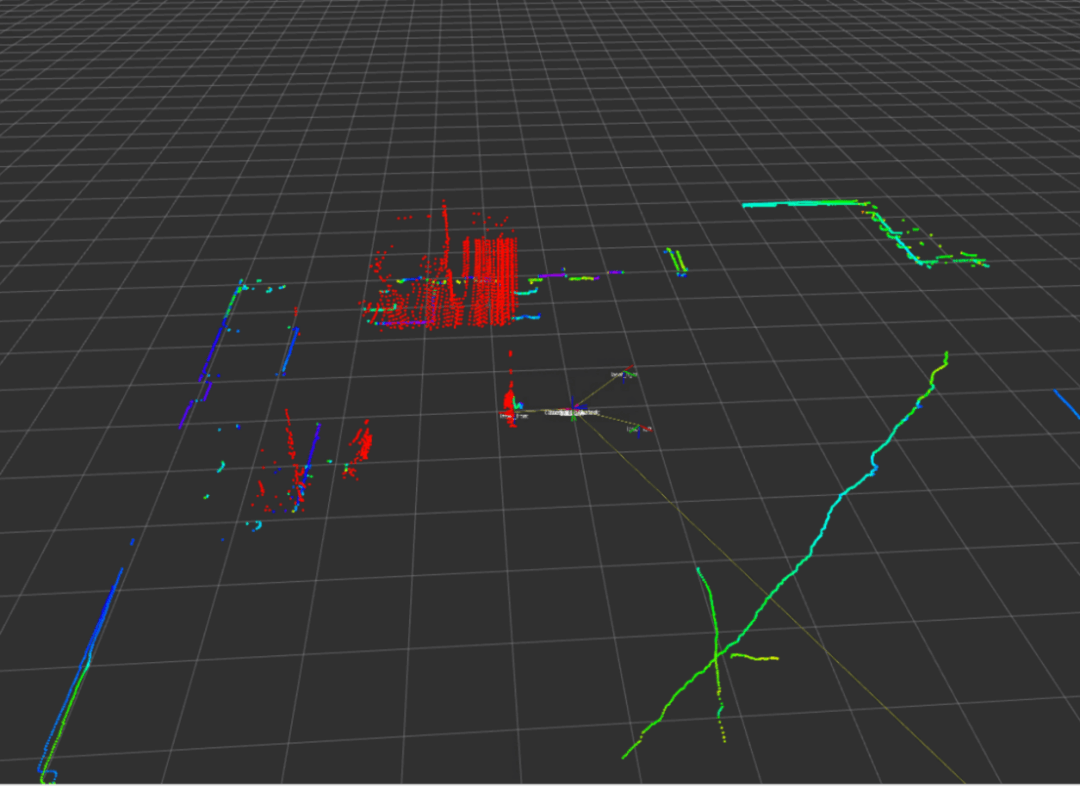

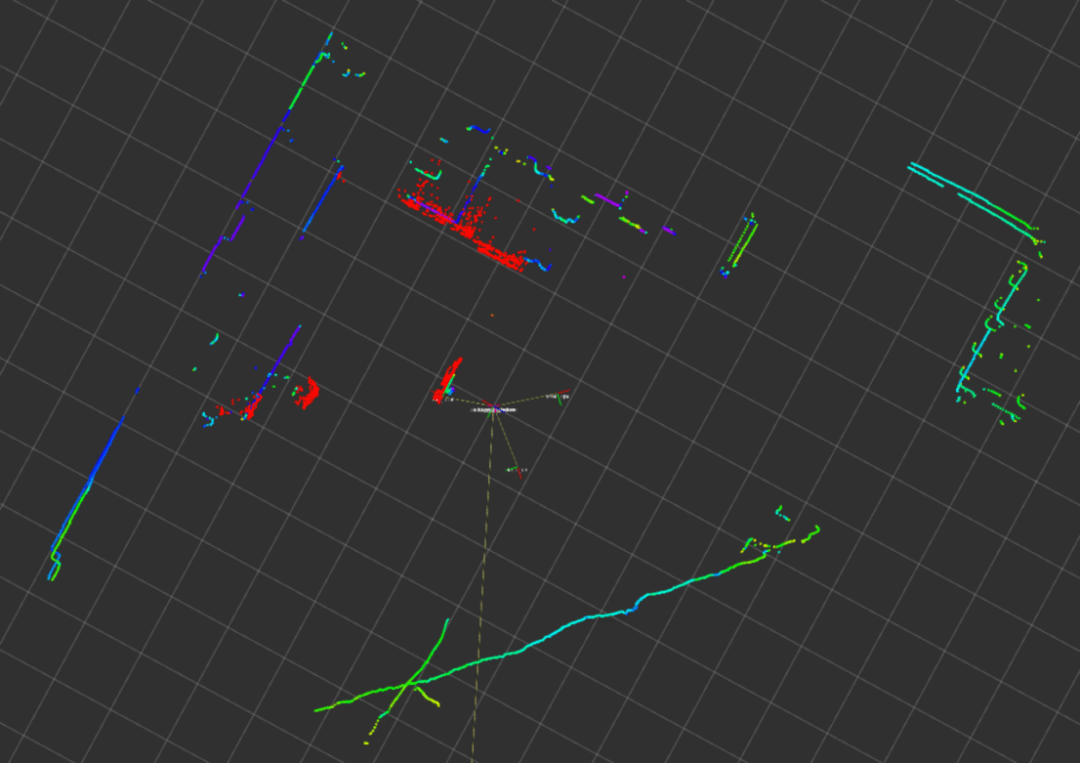

(↑2d与3d点云数据级融合纯点云地图(三维视角))

(↑2d与3d点云数据级融合纯点云地图(俯视视角))

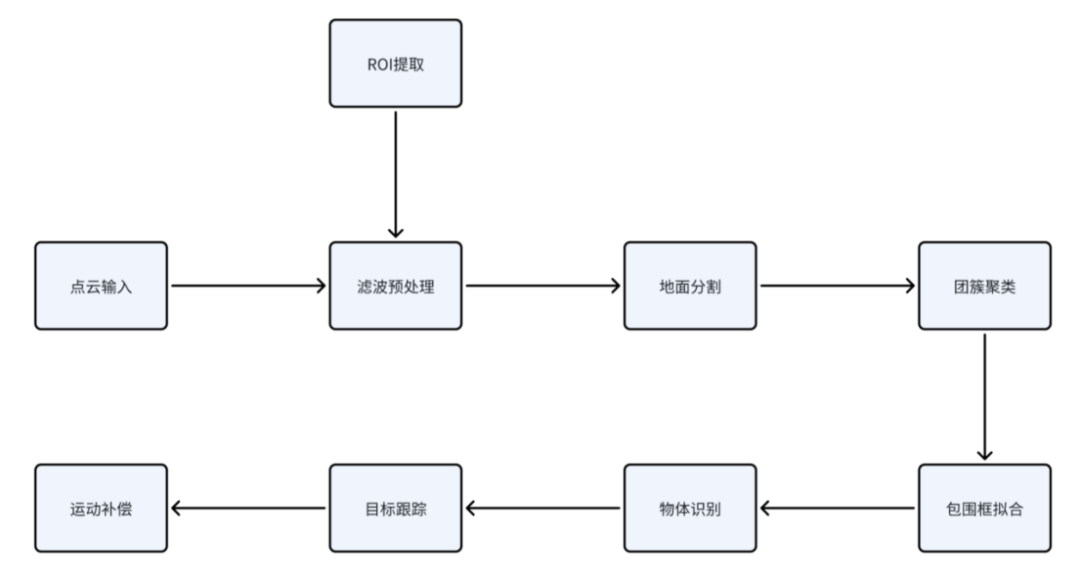

全局避障处理流程:针对点云数据量大且含噪声的问题,先进行滤波降采样;分割地面点云后,通过聚类算法分割地面障碍物团簇,拟合包围框标注中心/尺寸等属性;结合点云目标检测框架(如PointPillar)进行语义标注与跟踪,并构建卡尔曼滤波器平滑轨迹,同步优化算力保障实时性;存在运动畸变时需补偿校正。

(↑点云避障感知层算法框架)

4.实时避障算法

局部避障:深度相机覆盖车身近周区域,货叉IMU实时反馈姿态角,底部传感器监测空间障碍。

路径重规划:基于AGV速度(100-200ms周期),通过动态窗口法采样可行轨迹,预测动态障碍运动趋势,实时优化路径。

强化学习辅助:结合DQN、PPO等算法,在仿真环境中训练AGV适应复杂动态场景,提升自主决策能力。

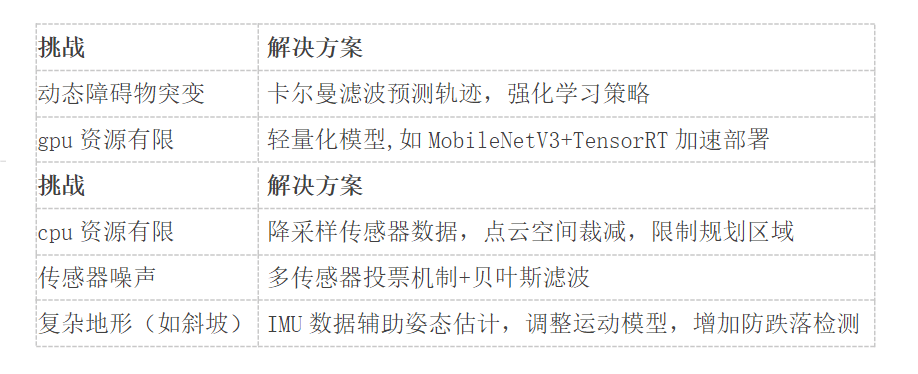

三、多传感器融合避障挑战与未来

1.AGV避障应用场景

AGV避障实际应用场景中,往往会遇到一些困难,以下列举一些挑战和解决方案:

2.未来方向

仿生策略:模仿蚁群/鸟群行为,预测动态障碍物轨迹。

神经融合:端到端模型(如PointNet+++Transformer)直接处理LiDAR与视觉数据。

类脑架构:脉冲神经网络(SNN)实现低功耗决策,LSTM+注意力机制预测长时序障碍物运动。

协同计算:云-边-端分层处理,降低车载算力压力。

仿真迁移:域随机化增强泛化性,在线自适应实时微调模型(如Meta-RL)。

群体智能:联邦学习优化多AGV路径,博弈论动态协调通行权。

目标:构建“感知-决策-控制”全链路智能化系统,通过生物启发算法、跨域协同(V2X/数字孪生)及高能效硬件,实现复杂环境下类人驾驶能力,兼顾安全、效率与伦理。

关注【海豚之星AiTEN】公众号,查看更多干货内容。